Virtual Production – Filmproduktion der Zukunft

Alles filmen können, ohne dass der entsprechende Ort überhaupt real existiert – geht das? Und noch viel wichtiger: Geht das auch in günstig?

Grosse Filmproduktionsstudios wie Disney mit «The Mandalorian» (https://www.youtube.com/watch?v=gUnxzVOs3rk) setzen für die Umsetzung ihrer Filme immer stärker auf Virtual Production anstatt auf Green Screens. So ist es möglich, die finale Szene bereits während der Aufnahme einigermassen abschätzen zu können, ausserdem können Darstellende so realistischer auf Effekte reagieren und das Licht stimmt auch schon. Kurz – Virtual Production wird immer mehr die Zukunft der modernen Filmproduktion.

Diese Systeme benötigen Unmengen an finanziellen Mitteln, können aber auch sehr viel einfacher umgesetzt werden, wenn auch mit grösserem Aufwand. So haben wir es uns zum Ziel gesetzt, ein einfaches Virtual-Production-Setup aufzusetzen, nur mit verfügbaren Mitteln aus der Technikausleihe der Fachhochschule. Den Beweis, dass solche Projekte tatsächlich mit wenig Budget realisiert werden können, kannst du hier begutachten:

Storyboard, Setup-FlowChart und Eindrücke der 3D-Welten:

(mst)

Das Projekt erhebt keinen Anspruch auf die beste Qualität, sondern fokussiert sich auf die «Lowest End Possibilities». Uns war es eher wichtig, als «Proof of Concept» zu zeigen, dass auch mit einfachen Mitteln ein ähnlich gutes Resultat erzielt werden kann, wie dies in modernen Filmen der Fall ist.

Preproduktion

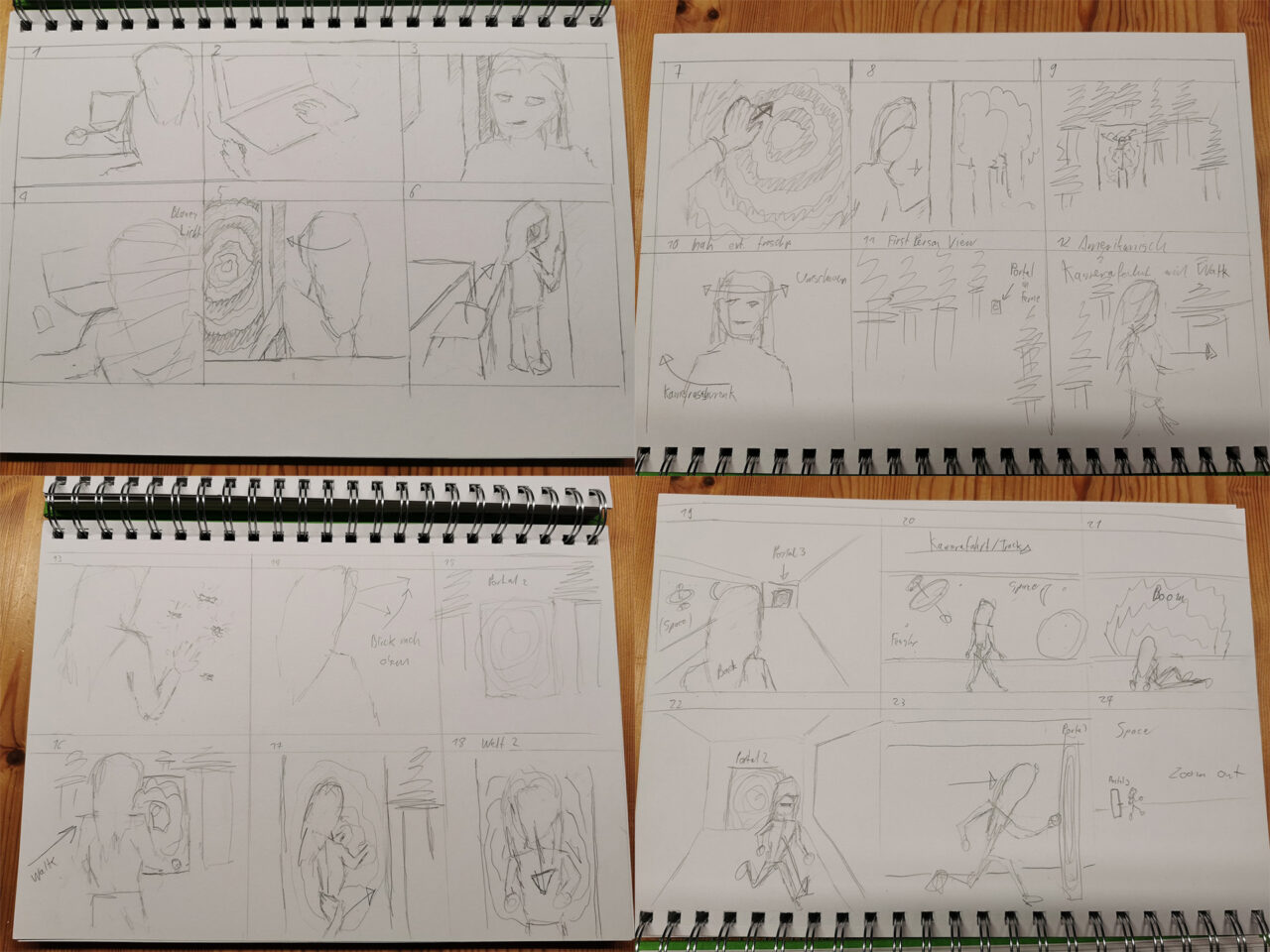

Das Storyboard war ein wichtiger Schritt in der Umsetzung. Es erlaubte uns besser zu verstehen, wie wir unsere Welten bauen wollen. Später konnten wir es als Referenz brauchen, um die virtuelle Kamera im Raum zu platzieren.

Der Bau der Welten hat etwas an Lego bauen erinnert. Durch gratis Pakete mussten wir die Assets nicht selber erstellen, sondern konnten aus bestehenden Modellen wie Türen, Lampen und Bäumen unsere eigene Welt erschaffen. Dabei kann man sich noch viel tiefer in das System einarbeiten, als wir das jetzt gemacht haben. Es besteht die Möglichkeit, die Welten zu animieren, einen Tag- und Nachtzyklus einzubauen, Lampen an und abzuschalten und noch vieles mehr. Da es sich mehr um ein «Proof of Concept» handelt, wollten wir uns aber auf einfache, aber eindrucksvolle Welten beschränken. So sind unsere Space Station und ein magischer Wald entstanden.

Aufnahme

Hier dürfen wir ein grosses Dankeschön an Sharon Peter aussprechen. Sie hat schon bei der Preproduktion viel mitgeholfen und Ideen angebracht und hat uns danach durch viele Stunden Aufnahmezeit als unsere Hauptdarstellerin (und einzige Darstellerin) begleitet. Ohne ihre Hilfe wäre das Projekt nicht zustande gekommen.

Aufgezeichnet haben wir im Log-Profil der Sony FX6 mit 10bit. Dies erlaubt uns, anschliessend in der Nachbearbeitung das Color Grading der Aufnahmen wesentlich besser aufeinander abzustimmen und so die Immersion des Videos aufzuwerten.

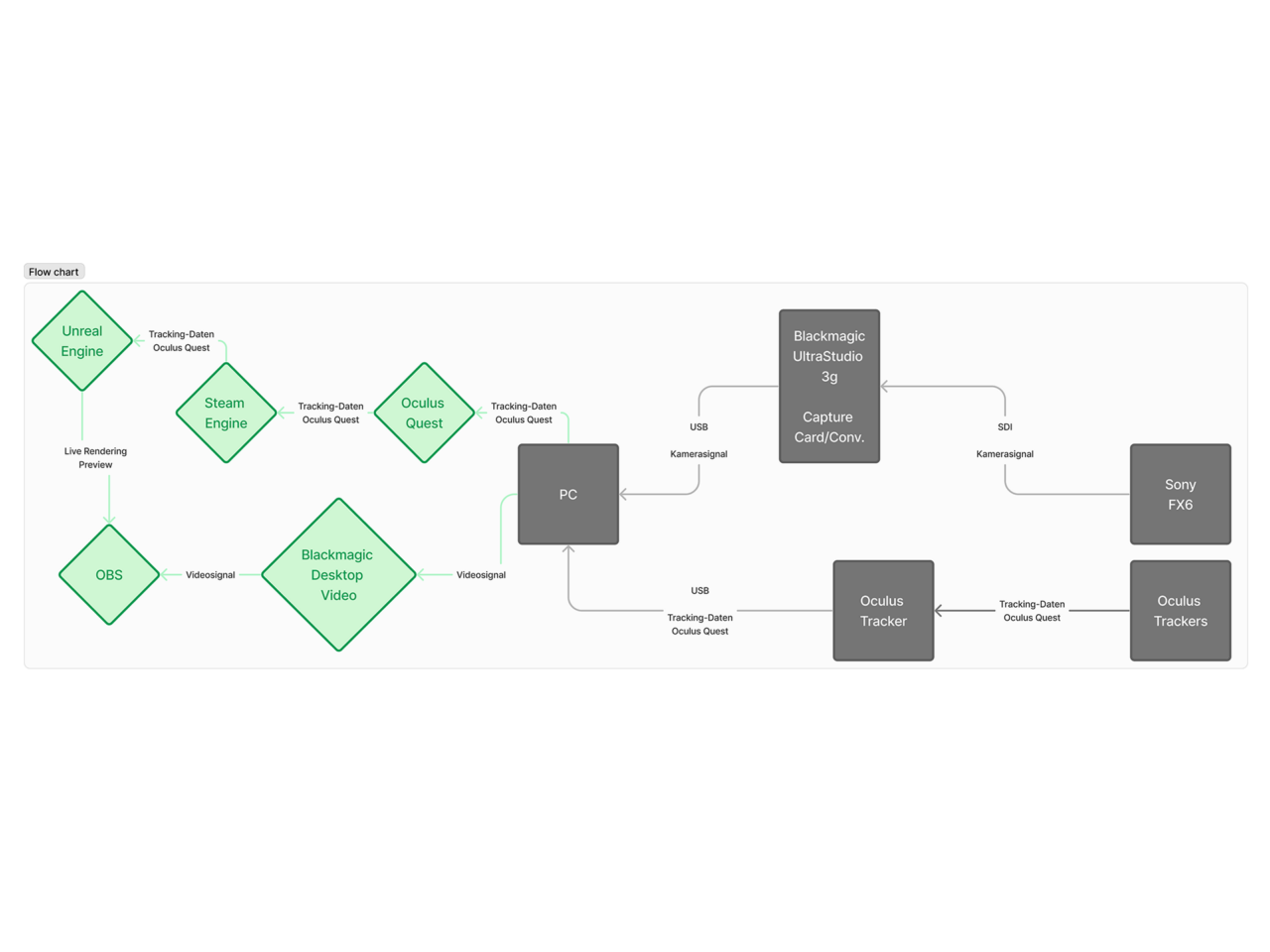

Everything works fine… niiiicht

Das Aufsetzen des Systems bereitete bereits einige Schwierigkeiten. Zwar waren alle benötigten Gerätschaften vorhanden, doch entgegen unserer Erwartung funktionierte nicht das ganze Setup wie gewünscht. Durch die Verschaltung der verschiedenen benötigten Softwares entstehen massive Abhängigkeiten bezüglich benötiger Treiber etc. Die Live-Vorschau innerhalb von OBS konnte dadurch nicht erreicht werden. Als Referenz wäre diese Live-Vorschau durchaus praktisch gewesen. So mussten wir mehrfach einfach ungefähr abschätzen, wo sich die Protagonistin im Raum befindet, oder in der Nachbearbeitung die Skalierung und Position innerhalb des Framings anpassen. Dabei ist uns aber das Storyboard sehr zugute gekommen.

Im Weiteren ist die Oculus Quest nicht per se auf Virtual Production ausgelegt oder optimiert. Das Tracking der Kamerabewegungen und der anschliessende Stream zur Unreal Engine zur Aufzeichnung funktionierte deshalb teilweise eher rucklig oder die Kamerabewegung konnte nicht vernünftig erfasst werden. Einige Aufnahmen mussten deshalb mehrfach durchgeführt werden. Dieses Problem könnte durch ein entsprechendes Tracking-System wie das Vive Mars System, welches auf diesen Anwendungsfall ausgelegt ist, umgangen werden. Leider stand uns ein entsprechendes System nicht zur Verfügung.

Ein weiterer Nachteil von Oculus ist die Tatsache, dass man nur über Steam VR das Oculus Headset mit der Unreal Engine verbinden kann. Somit muss man mehrere Leistungsintensive Programme gleichzeitig auf einem PC offen haben. Auf dem Mac würde das gar nicht erst funktionieren. Dies führte dazu, dass wir einen Desktop PC ins H8 geschleppt haben, um die Systeme überhaupt unterhalten zu können.

Postproduction

Die Nachbearbeitung wäre massiv einfacher, wenn die Aufnahmen mit Timecode-Generatoren durchgeführt werden. Anschliessend könnten die Aufnahmen aus Kamera und Unreal Engine einfach synchronisiert werden. In unserem Anwendungsfall mussten wir die Kamera zu Beginn jeder Aufzeichnung erkennbar hin- und herschwenken, um anschliessend im Schnittprogramm diese Bewegungen aufeinander abzustimmen.

Eine weitere starke Verbesserung wäre ein ebenfalls grüner Boden, passend zum Greenscreen. Durch den beschränkten Platz im Studio vor dem Greenscreen sowie den unpraktisch grauen Boden mussten die Aufnahmen mehrfach aufwändig Frame für Frame maskiert und animiert werden. Ausserdem blieben so vereinzelt Artefakte übrig, welche nicht genügend ausmaskiert werden konnten.

Visuelle Effekte haben wir in Davinci Resolve’s Fusion-Teil gebaut. Dies erforderte nochmals viel Zeit, weil wir uns beide nicht perfekt mit Fusion auskannten. Dennoch konnten wir nicht zuletzt durch dieses Projekt auch dort unsere Fähigkeiten verbessern.

Das Sounddesign wiederum war an die klassische Videografie angelehnt. Da wir auf der Kamera nur einen Scratch track hatten mussten wir alle Sounds selbst aufbauen. Die Produktion solcher Sounds alleine wäre ein Digezz-Projekt. Deshalb haben wir uns entschieden, alle Sounds von https://freesound.org/ zu nehmen. Mit über 30 verschiedenen Sound-Files wurde das Video zum Leben erweckt.

Learnings

Selbstverständlich kann die “Billigvariante” qualitativ nicht mit professionellen Projekten mithalten. Dennoch können einige Vorkehrungen getroffen werden, um die Aufnahmeerfahrung und die anschliessende Nachbearbeitung in Zukunft wesentlich angenehmer zu gestalten.

Folgende Dinge würden wir bei zukünftigen Virtual-Production-Aufnahmen beachten:

- Der Aufnahmebereich sollte komplett aus der selben Farbe bestehen. Dadurch erspart man sich in der Nachbearbeitung viele Stunden Rotoscoping.

- Das Aufnahmesystem mit der Oculus Quest erfordert, dass mehrere Programme parallel einwandfrei laufen. Hierzu ist neben einem leistungsstarken Rechner auch erforderlich, das erst kurz vor Aufnahmebeginn nochmals alle Programme simultan getestet und aktualisiert werden. Ansonsten kann eine Live-Referenz der beiden Videoebenen nicht erreicht werden.

- Professionelle Lösungen im Bereich Virtual Produktion werden immer billiger und besser. Somit kostet ein Vive Mars System unter 6000.- und ist im Umfang einer grossen Produktion ein kleiner Teil des Budgets. Dies erspart Zeit, Rechenleistung und ist sehr viel stabiler und besser als die Oculus, wenn es ums Tracking geht.

- Timecode-Generatoren für die einzelnen Geräte (Rechner, Kamera, evtl. auch Audio) vereinfachen die Synchronisierung der einzelnen Aufnahmen und führen so zu einer Zeitersparnis im Schnitt.

Fazit

Nach einer mehr oder weniger erfolgreichen Umsetzung stellen wir fest, wie unendlich viel Potenzial Virtual Production eigentlich hat. Nicht nur für professionelle Studios, sondern auch für Hobbyfilmer, die die Zuschauer: innen in eine interessante Welt eintauchen lassen wollen. Im Verlauf dieses Projektes sind uns so viele neue Ideen gekommen, dass wenn wir die alle umsetzen wollten, wir noch drei Jahre länger studieren müssten.